概要

2024年7月22日更新: この作品を根拠に、所属する立命館大学映像学部より、「映像学部の教学的取組み(学部の教育⽬標に密接に関連すると学部が認める取組みを含む)において優れた成果をあげたと認められる学⽣」に対して授与される『+R学部奨学金』の対象学生として採用頂きました。

詳細はこちらをご覧ください

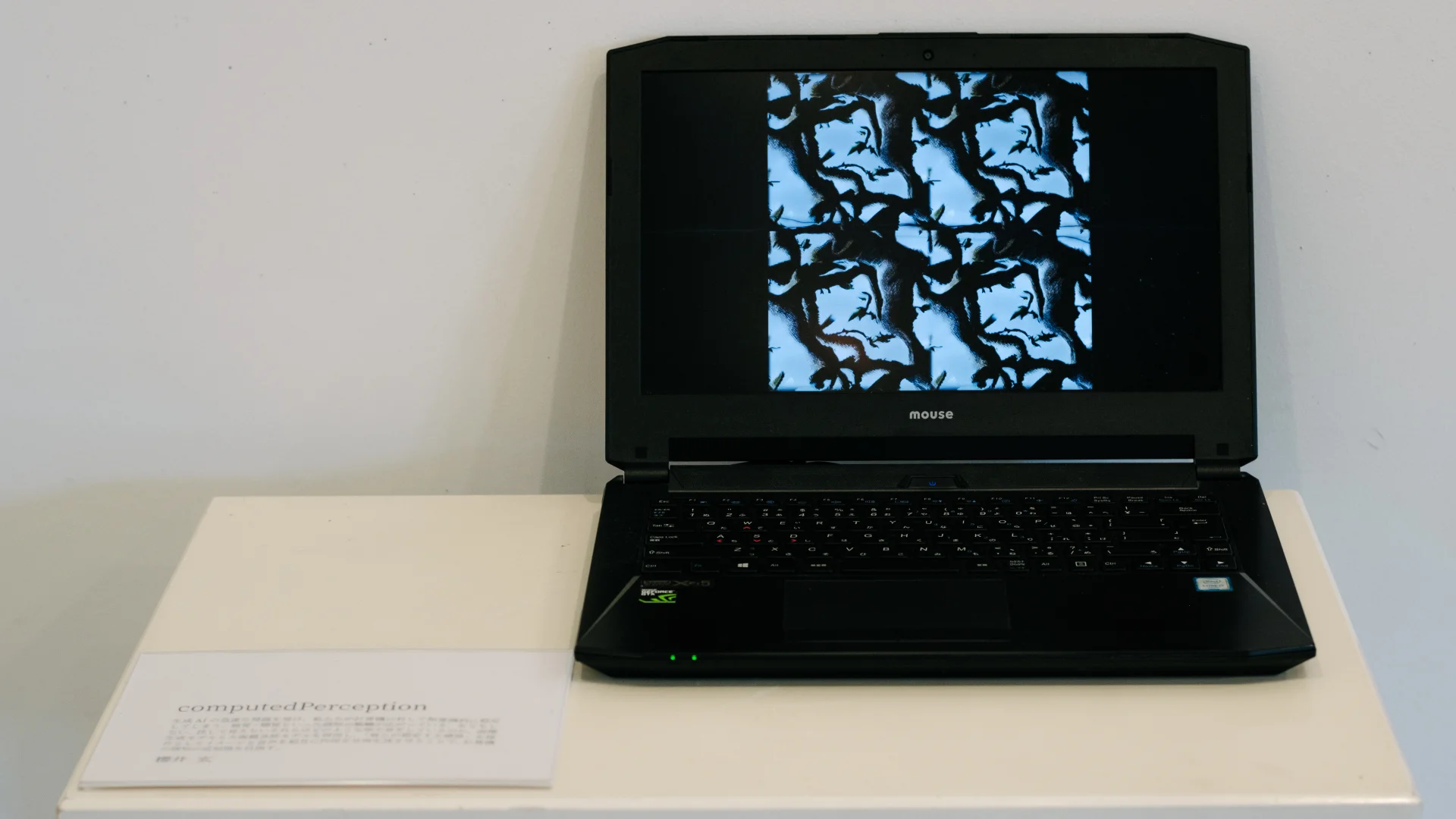

computedPerceptionは、生成AIの進化を受けAIに対して人間は何を思うのか、ということをテーマに制作しました。

人間固有の分野であった創作の領域に現れた機械に対して、私たちは自分とさほど変わらない感性をそれに期待し、まるで人間に指示をするかのように、機械にプロンプト文を打ち込んでいます。

我々が人間的な応答を機械に求めるのであれば、そこに現れる架空の"人間"は、何を見、何を聞いてきたのでしょうか。

画像と音声を相互かつ自律的に作用させることで、人間が考える「機械の見たもの・聞いたもの」に迫ることを目標としています。

技術詳細

本制作物は、Touchdesigner及びNode.js環境で実行されています。 Node.jsで動作しているプログラムは以下の処理を実行します。

以下における「音のパターン情報」とは、TidalCyclesで利用できる形のパターン文を指します。

- 画像生成プロセス

- 既に流されている音のパターン情報を大規模言語モデルに送信

- 大規模言語モデルが音のパターン情報をベースに画像生成用のプロンプト文を生成

- 画像生成モデルが画像を生成

- 音声生成プロセス

- 既に表示されている画像のキャプションをBLIPモデルで生成

- キャプション文を大規模言語モデルに送信

- 大規模言語モデルが新たな音のパターン情報を生成

紹介映像

リポジトリ

こちらからご確認ください。